La tecnologia avanza a fa passi da gigante, specialmente in campo AI. L’ultimo contributo rivoluzionario è stato introdotto dal team di ricerca di ControlNet con un nuovo articolo pubblicato la scorsa settimana, il quale rappresenta un grande passo avanti nella generazione di immagini e video attraverso l’AI. Questa tecnologia rende possibile utilizzare schizzi, contorni, mappe di profondità o pose umane per controllare i modelli di diffusione in maniera mai vista prima. In questo articolo, vediamo come questo innovativo sistema sta cambiando le regole, aprendo nuove frontiere di controllo sull’immagine e portandoci un passo più vicino a immagini AI completamente personalizzate e un illimitato controllo sul design.

ControlNET: la svolta che stavamo aspettando

La cosa rivoluzionaria di ControlNET è la sua soluzione al problema di consistenza spaziale. In precedenza, non esisteva un modo efficiente per dire a un modello AI quali parti dell’immagine di input mantenere. ControlNet cambia tutto ciò, introducendo un metodo per abilitare i modelli di Stable Diffusion all’utilizzo di condizioni di input aggiuntive per indicare al modello esattamente cosa fare.

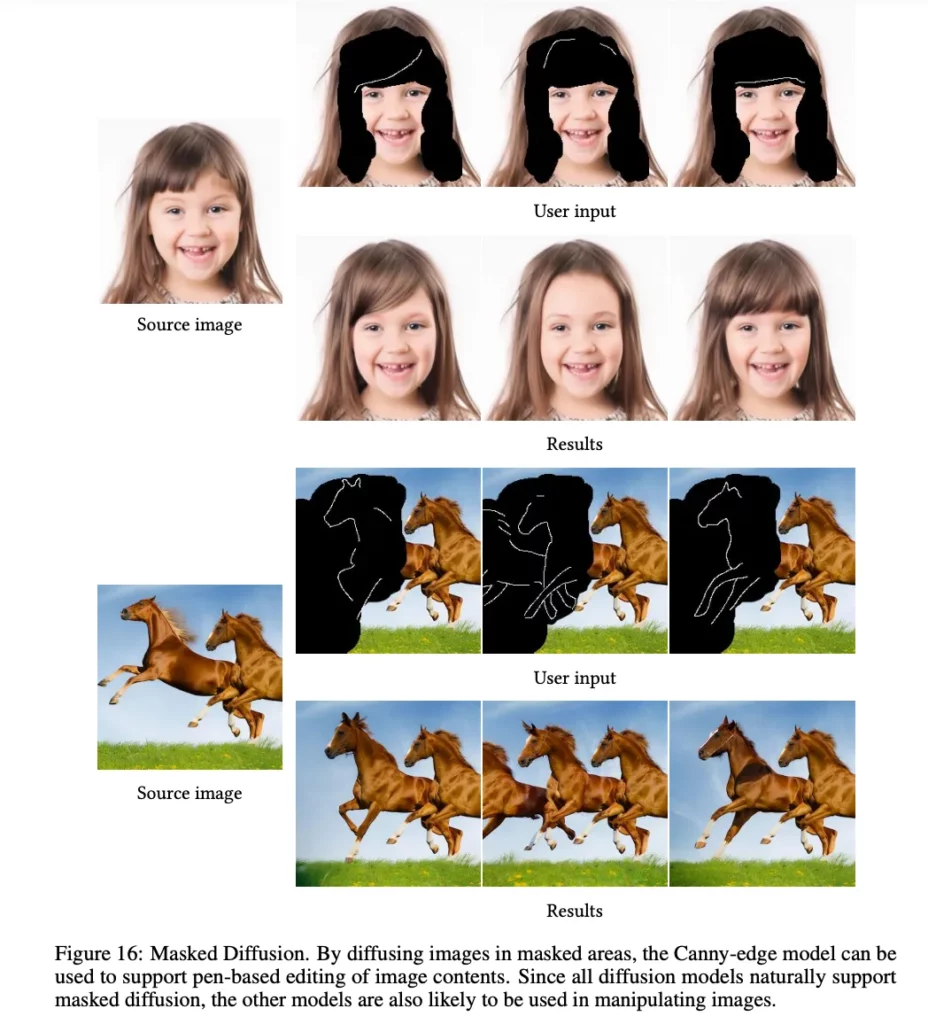

Inoltre, ControlNet lavora con la diffusione mascherata predefinita di Stable Diffusion. Il modello Canny Edge può essere utilizzato per controllare la manipolazione dell’immagine con la modifica manuale.

Ciò significa che ControlNET offre un controllo mai visto prima sulla creazione di immagini attraverso l’AI.

Esempi di ControlNET

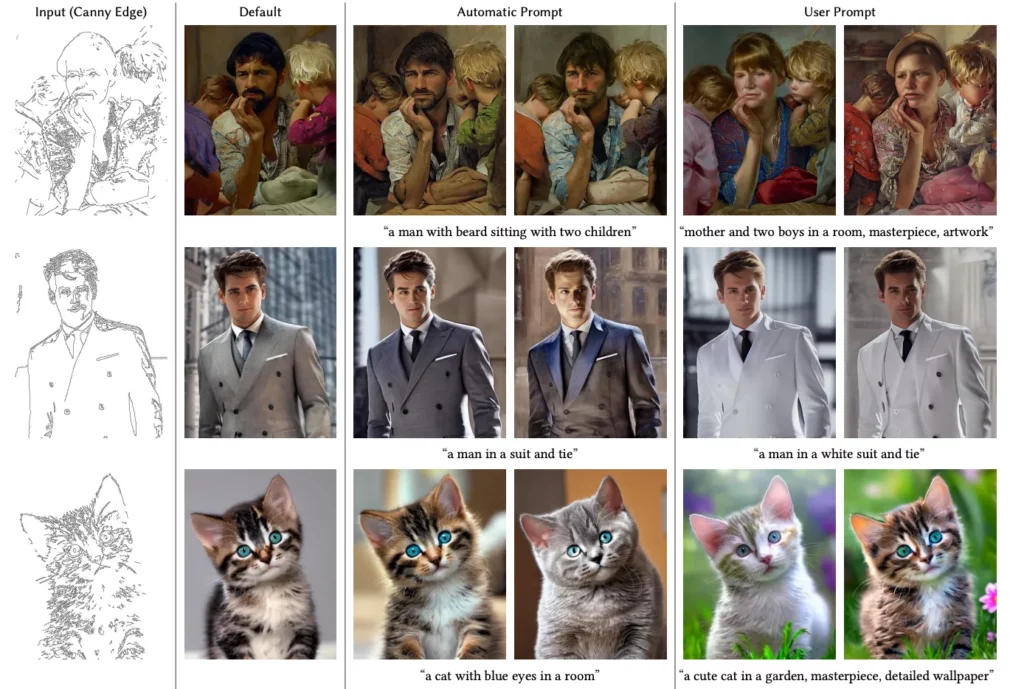

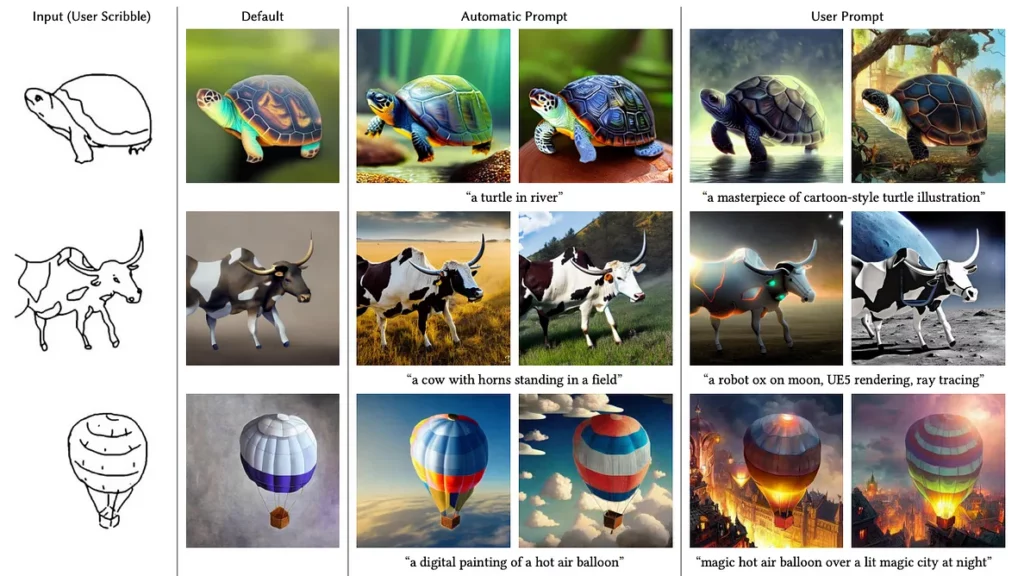

Per dimostrare le capacità di ControlNet, sono stati rilasciati numerosi modelli pre-istruiti che mostrano il controllo sulla generazione immagini in base a diverse condizioni, ad esempio, analisi delle informazioni sulla profondità, elaborazione dei tratti, o posizione umana, ecc. utilizza un algoritmo di rilevamento dei bordi per ricavare un’immagine Canny edge da un’immagine di input (“Default”), e poi utilizza entrambi per un’ulteriore generazione di immagini basata sulla diffusione:

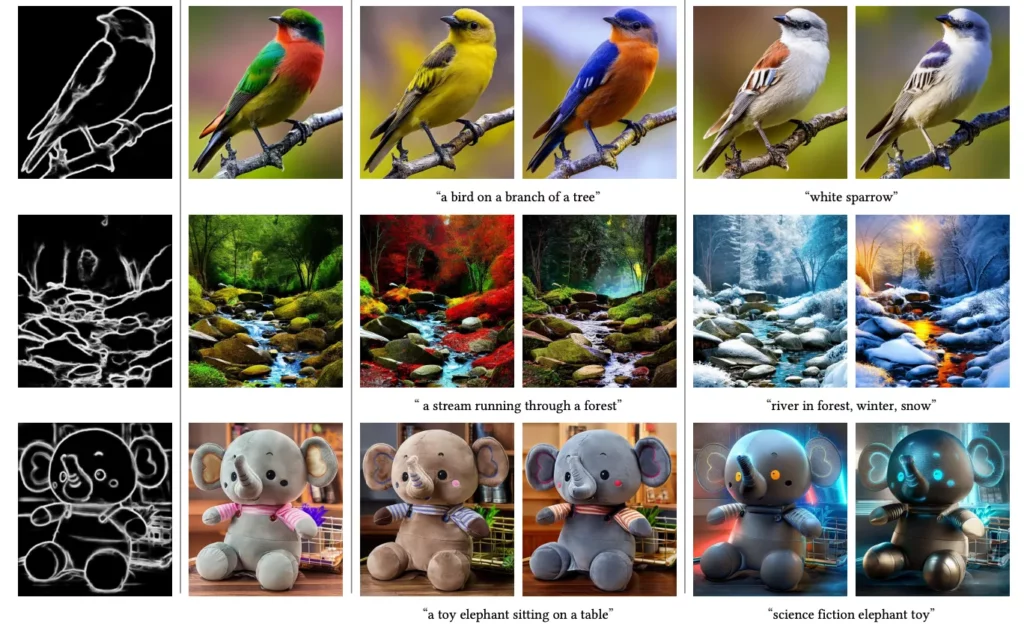

Ad esempio, il modello HED di ControlNet mostra il controllo su un’immagine di input attraverso il rilevamento del contorno.

Inoltre, il modello di rilevamento delle pose di ControlNet è incredibilmente preciso e consente di controllare l’immagine in base alle posizioni umane.

Altro esempio del modello HED di ControlNet che genera l’immagine di ingresso tramite il rilevamento dei contorni.

ControlNET funziona anche con la diffusione mascherata predefinita di Stable Diffusion. Ad esempio, il modello Canny Edge può essere utilizzato per controllare la manipolazione dell’immagine con l’editing manuale:

E questi sono solo alcuni esempi dei modelli presentati nell’articolo originale che hanno già portato allo sviluppo di una nuova generazione di toolkits per i creatori. Inoltre, con la consistenza spaziale risolta, ci si aspettano nuovi sviluppi avanzati anche nell’ambito della produzione dei video AI.

Implementazione ufficiale

L’implementazione ufficiale di ControlNe è disponibile su Github all’indirizzo https://github.com/lllyasviel/ControlNet.

Inoltre, c’è un tutorial su come installare e utilizzare la tecnologia su YouTube all’indirizzo https://www.youtube.com/watch?v=OxFcIv8Gq8o&t.

Un’interfaccia utente web per ControlNet è disponibile anche su Huggingface all’indirizzo https://huggingface.co/spaces/hysts/ControlNet.

Conclusioni

ControlNET e Stable Diffusion sono rivoluzionari per la creazione di immagini AI e il loro controllo. La soluzione di ControlNet al problema della consistenza spaziale rende possibile il controllo su tutte le parti dell’immagine di input, consentendo la creazione di immagini AI completamente personalizzate. L’implementazione ufficiale su Github, il tutorial su YouTube e l’interfaccia utente web su Huggingface rendono questa tecnologia accessibile a tutti. Non c’è da dubitare che ControlNET abbia aperto nuove frontiere di possibilità per la creazione di immagini AI personalizzate e altamente controllate, e le sue applicazioni potenziali sono illimitate.